| 작성자 | 장원준 |

| 일 시 | 2024. 5. 16 (목) 18:00 ~ 21:00 |

| 장 소 | 복지관 b128-1호 |

| 참가자 명단 | 임혜진, 이재영, 성창민, 김명원, 장원준 |

| 사 진 |  |

User parameter 없는 모델링 하려면 어떻게 할 수 있을까?

User parameter 가 없으면 좋은 이유

- User 마다 rank 만큼의 parameter가 필요한데 이렇게 되면 user 수가 많아졌을 때 메모리 사용량 과다해진다.

- 상호작용이 적은 (ex. 선호도 표현을 적게한) User 는 정확도가 낮다.

- User가 상호작용 할 때 마다 업데이트 해야한다.

아이템 집합을 입력받고, 추천 아이템들을 출력하는 모델을 만든다면 User의 상호작용이 늘어나도 재학습 할 필요가 없다.

이를 통해 제안된 방법이 두가지가 있는데 먼저 처음은,

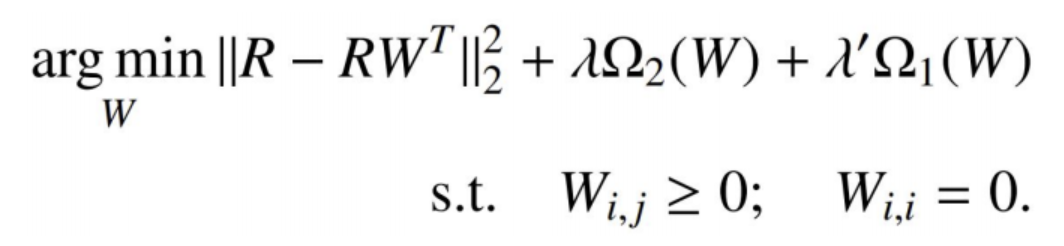

SLIM (Sparse Linear Methods)

slim은 유사도 기반 방법으로서 Cosine, Jaccard, Pearson 등 유사도 지표를 사용하는 대신, 아이템간 관련성을 데이터로부터 직접 학습하는 방법이다.

문제점 : W 가 꽉찬 |I| X |I| 행렬이다

해결책 : regularizer 를 사용하여 W를 sparse matrix로 만듦

FISM (Factored Item Similarity Methods)

User는 자신이 본 아이템들의 평균일 것이라는 아이디어로부터 user representation을 item representation의 평균으로 대체하는 방법이다.

FISM은 아이템 기반 협업 필터링과 행렬 분해 기법을 결합한 알고리즘으로, 대규모 데이터셋에서도 효과적인 추천을 제공할 수 있습니다. 사용자의 암시적 피드백을 고려하고 아이템 간 유사도를 활용하여 개인화된 추천을 생성하는 것이 FISM의 주요 특징입니다.

FISM의 장점은 아래와 같습니다.

- 개인화된 추천:

- FISM은 사용자 개인의 선호도를 반영하여 맞춤화된 추천을 제공합니다.

- 사용자가 선호하는 아이템과 유사한 아이템을 추천하여 사용자 만족도를 높일 수 있습니다.

- 확장성:

- FISM은 대규모 데이터셋에 대해서도 효율적으로 동작할 수 있습니다.

- 행렬 분해 기법을 사용하여 계산 복잡도를 줄이고, 병렬 처리 등을 통해 확장성을 높일 수 있습니다.

- 암시적 피드백 활용:

- FISM은 사용자의 명시적인 평점 정보뿐만 아니라 암시적인 피드백(예: 클릭, 구매, 시청 등)도 고려할 수 있습니다.

- 암시적 피드백을 통해 사용자의 선호도를 추론하고 추천에 반영하여 더 풍부한 정보를 활용할 수 있습니다.

- Cold-start 문제 완화:

- FISM은 새로운 사용자나 새로운 아이템에 대해서도 어느 정도 추천이 가능합니다.

- 아이템 간 유사도를 기반으로 추천하므로, 새로운 아이템이 추가되어도 유사한 아이템과의 관계를 통해 추천할 수 있습니다.

- 아이템 간 유사도 활용:

- FISM은 아이템 간의 유사도를 기반으로 추천을 수행합니다.

- 사용자가 선호하는 아이템과 유사한 아이템을 찾아 추천하므로, 사용자의 관심사에 부합하는 아이템을 제안할 수 있습니다.

- 행렬 분해 기법 사용:

- FISM은 행렬 분해 기법을 사용하여 아이템 간의 잠재 요인을 학습합니다.

- 이를 통해 아이템 간의 복잡한 관계를 효과적으로 포착하고 추천의 정확도를 높일 수 있습니다.

- 협업 필터링의 장점 활용:

- FISM은 협업 필터링 기반의 알고리즘으로, 사용자 간의 선호도 유사성을 활용합니다.

- 비슷한 선호도를 가진 사용자들의 정보를 바탕으로 추천을 생성하므로, 사용자 간의 협업 효과를 얻을 수 있습니다

user parameter 가 없는 모델일 때 확실히 시간 복잡도가 떨어진다는 것을 알 수 있었고, 여기서 더 발전할 수 있는 방법을 알아봐야겠다.